Die offensichtliche Lösung wäre die Deckung des zunehmenden Strombedarfs aus Wind-, Sonnen- und Wasserkraft. In Großbritannien wurde im vergangenen Jahr genug saubere Energie erzeugt, um sämtliche Haushalte zu versorgen. Problematisch wird es, wenn man versucht, die grünen Elektronen in der Nachfragesteuerung der Versorgungsunternehmen einzusetzen. Mousavi verweist auf US-Bundesstaaten wie Kalifornien und Texas, die massiv in den Ausbau der erneuerbaren Energien investiert haben. „Das Netz ist nicht dafür optimiert, erneuerbare Energie dorthin zu bringen, wo sie gebraucht wird. Wenn die Übertragungskapazitäten für erneuerbare Energien nicht ausreichen, vor allem zu Spitzenzeiten wie mittags bei der Solarenergie, haben sie keine andere Wahl, als auf Drosselungen zurückzugreifen, d. h. erneuerbare Energiequellen einfach vom Netz zu trennen.“

Als Paradebeispiel führt er die umfangreichen Investitionen in Solaranlagen im kalifornischen Central Valley an. „Das Netz muss erst noch entsprechend aufgerüstet werden, um den Großteil des im Großraum San Francisco nachgefragten Stroms von den Orten im Central Valley zu übertragen, wo die Solarstromerzeugungskapazität stark gestiegen ist, wie z. B. in den Außenbezirken von Davis und Merced“, führt er an. „Also gibt es in der Bay Area zwar eine hohe Verbrauchsnachfrage, aber nicht die geeignete Netzinfrastruktur, um die gesamte nachgefragte erneuerbare Energie dorthin zu liefern. Das führt dazu, dass die verfügbaren erneuerbaren Energiequellen wie die Solarenergie während der Nachfragespitzen abgeschaltet werden, um die Stabilität des Stromnetzes aufrechtzuerhalten, und stattdessen herkömmliche Kraftwerke zu Zeiten hoher Nachfrage im lokalen Verbrauchsgebiet eingesetzt werden.“

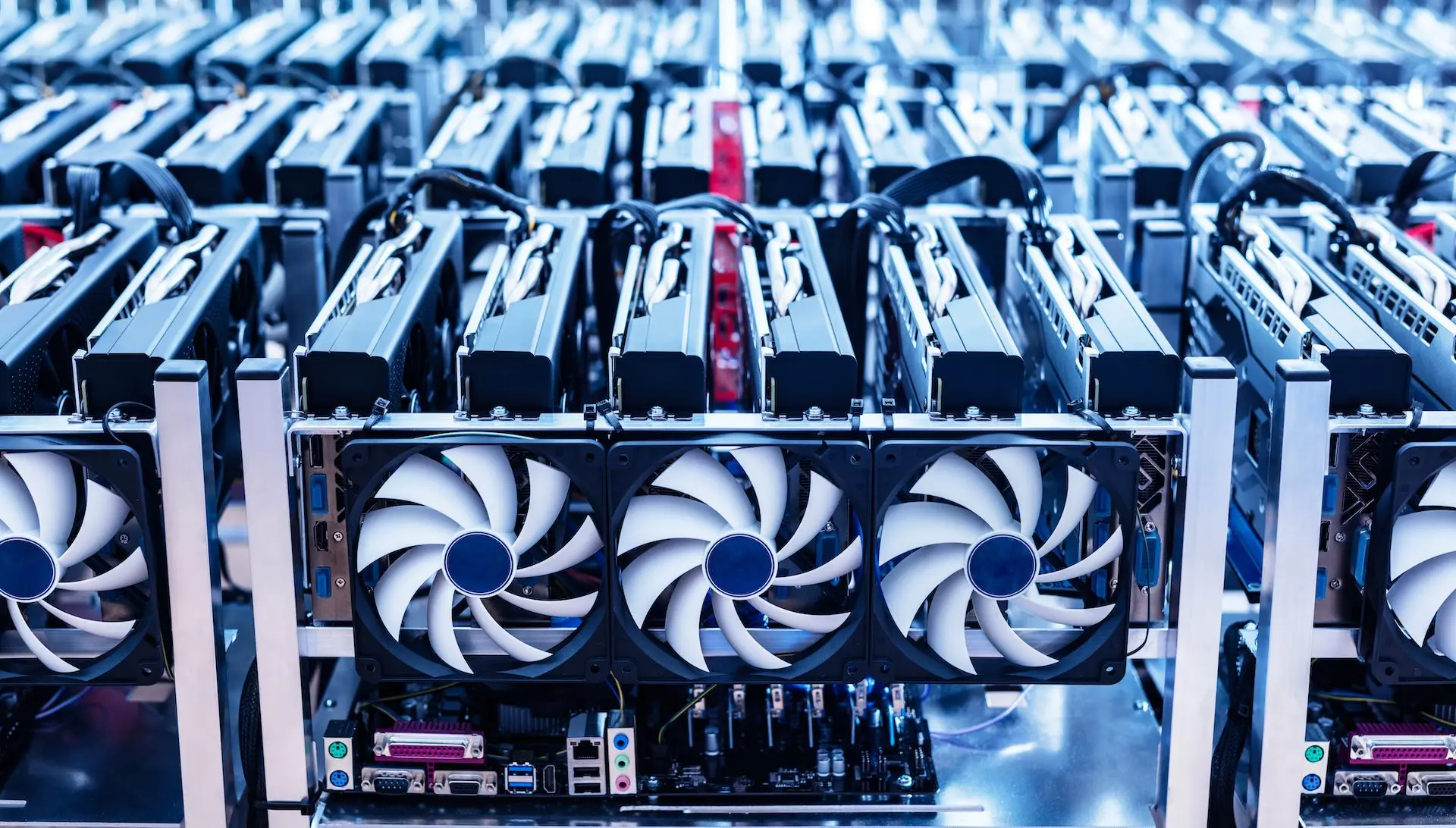

Investitionen in die Infrastruktur versprechen zwar Abhilfe, jedoch kann der Ausbau des Stromnetzes sich über Jahre oder sogar Jahrzehnte hinziehen. Was kann man heute zur Bewältigung des steigenden Strombedarfs durch KI tun? Eine Möglichkeit besteht darin, die Rechenkapazität zu rationieren, wie es Amazon Web Services Berichten zufolge in Irland tun musste, oder Anreize für die Verlagerung und den Ausbau von Rechenkapazitäten in Gebiete zu schaffen, in denen erneuerbare Energien im Überfluss vorhanden sind. Dadurch ließe sich der zusätzliche Druck auf das Stromnetz verringern, der durch das Zusammentreffen stark erhöhter Nachfrage mit der Umstellung auf erneuerbare Quellen entsteht. Eine Alternative wäre, weiterhin fossile Brennstoffe zu verbrennen. Trotz aller Probleme sind Öl- und Gaskraftwerke reichlich vorhanden, zuverlässig und gleichmäßig in der Nähe großer Bevölkerungszentren verteilt.

Je mehr diese Energieträger jedoch genutzt werden, desto weniger dringlich erscheint es, neue saubere Kraftwerke in Betrieb zu nehmen. In den USA gibt es eine lange Liste von Projekten für erneuerbare Energieträger, deren behördliche Genehmigung noch aussteht. Im Zuge der zunehmenden Nutzung von KI nicht nur in der Wirtschaft, sondern auch in Privathaushalten könnte sich die Realisierung solcher Projekte weiter verzögern.

Vor diesem Hintergrund setzen Rechenzentren teilweise auf Umgehungslösungen wie Stromabnahmevereinbarungen (PPAs) und Zertifikate für erneuerbare Energien (RECs), um ihre CO2-Bilanz auszugleichen. „PPAs und RECs sind zwei der wichtigsten Faktoren für eine verstärkte Stromerzeugung, und obwohl sie ein Segen für die erneuerbare Energiebranche waren, sind sie absolut kein Allheilmittel“, mahnt Mousavi. „Sie tragen nicht viel dazu bei, die Übertragung zu verbessern oder funktionierende Mechanismen für die Rechenschaftspflicht durch eine ordnungsgemäße Zuweisung der Emissionsverantwortung an die Endverbraucher zu schaffen. Zudem macht der Handel mit Emissionsattributen durch Mechanismen wie RECs es praktisch unmöglich, die reale Treibhausbilanz eines Unternehmens zu ermitteln.“

Unter Berufung auf eine Ende 2023 veröffentlichte kritische Stellungnahme zur marktbasierten Berechnung der indirekten Treibhausgasemissionen gemäß Scope 2 fordert Mousavii: „Wir müssen das Gleichgewicht zwischen Produktion und Nachfrage nach erneuerbaren Energien verbessern. Wir haben die saubere Stromerzeugung in den letzten Jahren rapide gesteigert, aber wir haben es versäumt, die Infrastruktur zu verbessern, um diese erhöhte Erzeugungskapazität dorthin zu liefern, wo die Nachfrage besteht.“